15/05/2025

Transfer Learning là gì và vì sao ngày càng được ứng dụng rộng rãi? Đây là kỹ thuật giúp tăng hiệu quả học máy bằng cách tái sử dụng kiến thức từ mô hình có sẵn. Bài viết sẽ giúp bạn hiểu cách hoạt động, lợi ích, ứng dụng và thời điểm nên áp dụng. Cùng Wi Team khám phá ngay nhé.

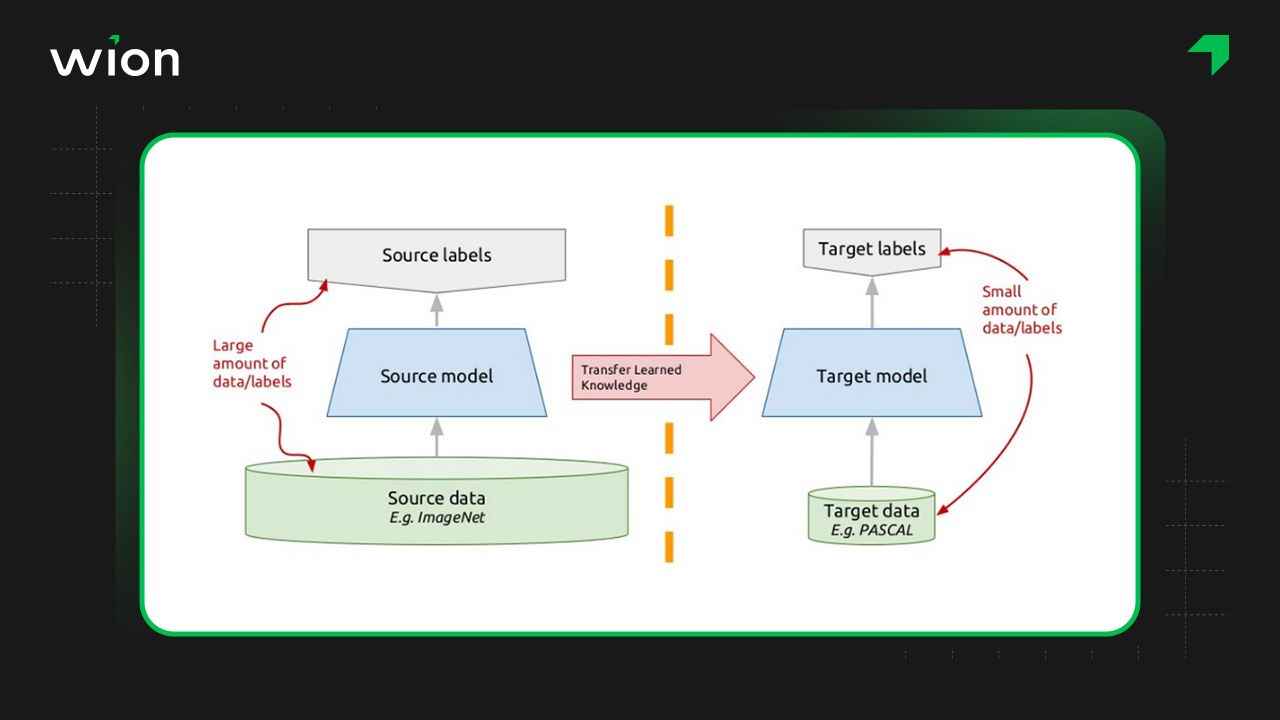

Transfer Learning (học chuyển giao) là một phương pháp trong học máy, cho phép chuyển giao kiến thức từ một mô hình đã được huấn luyện trước sang một nhiệm vụ mới. Thay vì huấn luyện mô hình từ đầu, Transfer Learning tận dụng mô hình đã được huấn luyện để rút ngắn thời gian học và tăng độ chính xác trên tác vụ mới.

Cụ thể hơn, trong học chuyển giao, kiến thức mà một mô hình đã học được từ một tác vụ hoặc tập dữ liệu ban đầu (gọi là source task/data) sẽ được tái sử dụng để cải thiện hiệu suất của mô hình khi giải quyết một tác vụ hoặc tập dữ liệu mới nhưng có liên quan (gọi là target task/data).

Giả sử bạn có một mô hình Deep Learning đã được huấn luyện để phân loại mèo và chó. Khi cần phân biệt hổ và sư tử, thay vì tạo mô hình mới và huấn luyện lại. Bạn dùng lại mô hình cũ (đã học các đặc điểm tai, mắt, lông thú, v.v.) và tinh chỉnh để phù hợp với nhiệm vụ mới.

Để hiểu rõ học chuyển giao là gì và cách nó hoạt động, chúng ta sẽ cùng tìm hiểu các bước cơ bản trong quy trình áp dụng học chuyển giao vào các mô hình AI hẹp.

Mô hình nguồn hay mô hình cơ sở là mạng nơ-ron đã được huấn luyện trước trên bộ dữ liệu lớn như ImageNet hoặc Wikipedia Corpus. Mô hình này thường đến từ các tập đoàn công nghệ lớn, được công khai và cho phép tái sử dụng để phát triển mạng thần kinh để giải quyết bài toán cụ thể.

Sau khi tải mô hình nguồn từ các thư viện như TensorFlow Hub hay PyTorch Hub, bạn có thể tùy chỉnh các lớp, trọng số để phù hợp với tác vụ cụ thể. Thông thường, quá trình này gồm loại bỏ lớp cuối và thêm lớp mới, giúp mô hình hoạt động hiệu quả hơn với dữ liệu của bạn.

Các lớp dưới cùng và giữa giữ lại tính năng chung, còn lớp trên cùng thể hiện đặc trưng riêng của bài toán ban đầu. Khi điều chỉnh mô hình, bạn cần loại bỏ lớp trên, thêm tác vụ mới và huấn luyện lại trên dữ liệu riêng để đạt độ chính xác cao hơn với thời gian huấn luyện ngắn hơn.

Để hiểu rõ hơn Transfer Learning là gì và các phương pháp áp dụng của nó, chúng ta cần tìm hiểu về các dạng học chuyển giao khác nhau. Mỗi dạng sẽ có những ứng dụng riêng biệt tùy theo đặc điểm của bài toán và dữ liệu. Dưới đây là ba dạng học chuyển giao phổ biến.

Học chuyển giao thường được dùng khi nhiệm vụ gốc và mục tiêu khác nhau. Ví dụ, mô hình trích xuất đặc trưng từ ảnh đã huấn luyện trước có thể tiếp tục huấn luyện để nhận diện vật thể, giúp tiết kiệm thời gian và tận dụng hiệu quả kiến thức đã học từ dữ liệu lớn ban đầu.

Unsupervised Transfer Learning khác với Inductive Transfer ở chỗ cả dữ liệu nguồn và dữ liệu mục tiêu đều không có nhãn (unlabeled data). Không cần con người can thiệp để gán nhãn dữ liệu, mô hình học từ các mẫu bất thường. Phương pháp này thường được dùng trong phát hiện gian lận từ các giao dịch không gắn nhãn.

Transductive Transfer Learning được dùng khi nhiệm vụ giống nhau nhưng dữ liệu khác biệt, với dữ liệu gốc có nhãn và dữ liệu mục tiêu không có nhãn. Ví dụ, mô hình phân loại đánh giá nhà hàng có thể được áp dụng để phân loại đánh giá phim mà không cần gắn nhãn lại toàn bộ dữ liệu mới.

Khi khám phá học chuyển giao là gì, bạn sẽ nhận thấy công nghệ này mang lại nhiều lợi ích đáng kể. Dưới đây là các ưu điểm nổi bật của học chuyển giao.

Đào tạo mô hình Machine Learning từ đầu tốn nhiều thời gian, dữ liệu và tài nguyên. Trong khi đó, Transfer Learning sử dụng mô hình đã huấn luyện trước, giữ lại kiến thức cốt lõi và thích ứng nhanh với nhiệm vụ mới. Nhờ đó, bạn chỉ cần ít dữ liệu và tài nguyên hơn nhưng vẫn đạt kết quả tốt.

Giống AI tạo sinh, một thách thức lớn trong huấn luyện mô hình là thiếu dữ liệu chất lượng cao. Học chuyển giao giúp giải quyết bằng cách sử dụng mô hình đã huấn luyện trước, vốn đã học được những đặc trưng quan trọng. Nhờ đó, bạn có thể giảm đáng kể nhu cầu về dữ liệu lớn mà vẫn đạt hiệu quả cao.

Xây dựng mạng nơ-ron sâu cần nhiều dữ liệu, thời gian và tài nguyên. Transfer Learning giúp vượt qua những rào cản này bằng cách cho phép điều chỉnh mô hình đã huấn luyện theo nhu cầu cụ thể. Nhờ đó, bạn có thể áp dụng vào các bài toán như phân tích ảnh y tế hay nhận dạng khuôn mặt với chi phí thấp.

Các mô hình phát triển từ Transfer Learning thường mạnh mẽ hơn trong môi trường thực tế đầy biến động. Nhờ được huấn luyện trên dữ liệu đa dạng ban đầu, chúng xử lý tốt hơn tiếng ồn, sự thay đổi và dễ dàng thích nghi với điều kiện không lường trước, mang lại kết quả ổn định và hiệu quả cao hơn.

Sau khi hiểu rõ Transfer Learning là gì và những lợi ích mà nó mang lại, bạn cũng nên cân nhắc một vài điểm hạn chế có thể ảnh hưởng đến hiệu quả khi áp dụng trong thực tế.

Học chuyển giao hoạt động hiệu quả khi nhiệm vụ ban đầu và nhiệm vụ mục tiêu có mức độ tương đồng, chẳng hạn như cùng loại dữ liệu hoặc mục tiêu phân tích. Nếu hai nhiệm vụ quá khác biệt, mô hình sẽ khó khai thác được các đặc trưng hữu ích đã học trước đó, dẫn đến kết quả không như mong đợi.

Một thách thức trong Transfer Learning là thiếu tiêu chuẩn đánh giá sự tương đồng giữa các nhiệm vụ. Dù đã có một số phương pháp được đề xuất, hiện vẫn chưa có tiêu chuẩn chung được chấp nhận rộng rãi để xác định liệu chuyển giao kiến thức có thực sự mang lại hiệu quả trong từng trường hợp hay không.

Khi tìm hiểu về học chuyển giao là gì, chúng ta sẽ thấy công nghệ này mang lại nhiều ứng dụng quan trọng trong các lĩnh vực khác nhau. Dưới đây là một số ứng dụng nổi bật của Transfer Learning.

Thị giác máy tính cũng như AGI, nhận diện hình ảnh là ứng dụng phổ biến của Transfer Learning, đặc biệt với mô hình học sâu như CNNs. Sau khi được huấn luyện trên tập dữ liệu lớn như ImageNet, các mô hình này có thể được điều chỉnh để nhận diện đối tượng trong ảnh y tế hoặc khuôn mặt trong hệ thống an ninh hiệu quả.

Giống Conversational AI cũng được ứng dụng NLP, Transfer Learning thể hiện sức mạnh qua các mô hình như BERT, GPT, T5. Khi được tích hợp vào phần mềm chatbot, nhờ được huấn luyện trên dữ liệu khổng lồ, chúng giúp thực hiện các tác vụ như phân loại, tóm tắt, dịch ngôn ngữ chính xác mà không cần huấn luyện lại từ đầu.

Pre-trained model là mô hình máy học đã được huấn luyện sẵn trên các tập dữ liệu lớn như ImageNet. Nhờ đó, mô hình học được nhiều đặc trưng quan trọng, có thể dùng làm bộ trích xuất đặc trưng hoặc phân loại cho các bài toán mới mà không cần huấn luyện lại từ đầu, giúp tiết kiệm nguồn lực đáng kể.

Sử dụng pre-trained model giúp tiết kiệm thời gian, chi phí và nâng cao độ chính xác của hệ thống. Chúng được ứng dụng rộng rãi trong xử lý ngôn ngữ tự nhiên, phân loại ảnh và nhận dạng giọng nói, đặc biệt hiệu quả khi dữ liệu huấn luyện mới bị hạn chế hoặc phân bố không đồng đều.

Sau khi biết học chuyển giao là gì, để hiểu rõ hơn về các mô hình Pre-trained, và cách thức các mô hình này được áp dụng để học từ dữ liệu đã huấn luyện sẵn, dưới đây là 4 mô hình Pre-trained phổ biến mà bạn có thể tham khảo

Mô hình VGG19 là mạng thần kinh tích chập 19 lớp, được xây dựng và huấn luyện vào năm 2014. Sử dụng hơn 1 triệu hình ảnh từ ImageNet, bao gồm hình ảnh màu 224×224 pixel, mô hình pre-trained này có thể phân loại 1000 đối tượng khác nhau và cho phép nhập các trọng số huấn luyện từ ImageNet để cải thiện hiệu suất.

Kích thước, hiệu suất của mô hình này như sau:

Mô hình pre-trained Inceptionv3 là mạng thần kinh tích chập 50 lớp, sử dụng cơ sở dữ liệu ImageNet và có khả năng phân loại tới 1000 đối tượng. Kích thước ảnh đầu vào của mô hình là 299×299 pixel, cho phép truy cập tất cả thông tin và dữ liệu từ bài báo để thực hiện các phân tích chính xác.

Kích thước, hiệu suất của mô hình này như sau:

Mô hình ResNet50 là mạng thần kinh tích chập 50 lớp, phát triển bởi Microsoft vào năm 2015. Sử dụng 1 triệu hình ảnh từ ImageNet, mô hình này có khả năng phân loại 1000 đối tượng, với kích thước ảnh 224×224 pixel. So với VGG19, ResNet50 mang lại hiệu quả cải thiện đáng kể dù có độ phức tạp thấp hơn.

Kích thước, hiệu suất của mô hình này như sau:

EfficientNet là mạng thần kinh tích chập tiên tiến do Google phát triển năm 2019, gồm 8 phiên bản thay thế với 5,3 triệu tham số. Mô hình này đạt độ chính xác Top-1 lên đến 77,1%, mang lại hiệu suất cao với kiến trúc tối ưu, phù hợp cho nhiều nhiệm vụ thị giác máy tính hiện đại.

Kích thước, hiệu suất của mô hình này như sau:

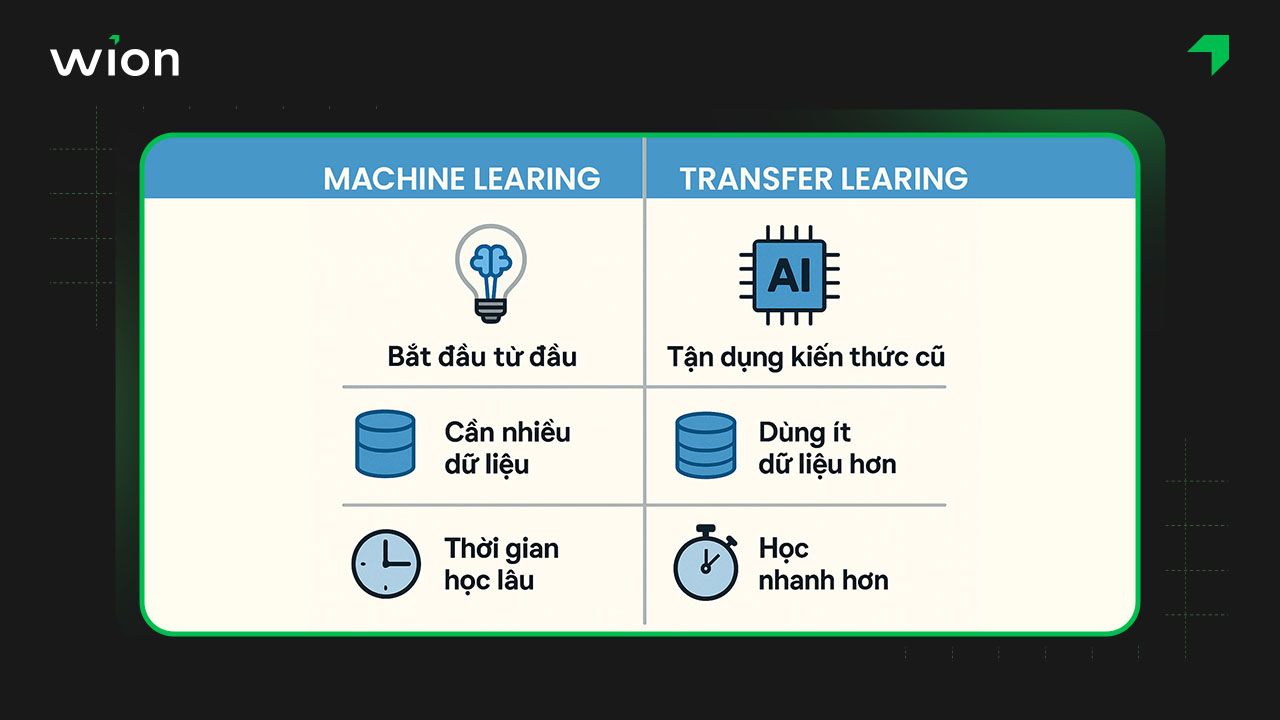

Để hiểu rõ hơn Transfer Learning là gì và khác gì so với phương pháp học máy truyền thống, dưới đây là bảng so sánh ngắn gọn giữa Transfer Learning và Machine Learning dựa trên các tiêu chí phổ biến.

| Tiêu chí | Machine Learning | Transfer Learning |

| Cách học | Mỗi mô hình học từ đầu cho từng bài toán cụ thể. | Dùng kiến thức từ mô hình đã học để giải quyết bài toán mới. |

| Khả năng tận dụng kiến thức cũ | Không có – các mô hình hoạt động độc lập. | Có – kiến thức từ tác vụ trước được truyền sang tác vụ mới. |

| Tối ưu thời gian & tài nguyên | Mất thời gian và tài nguyên để huấn luyện từ đầu. | Tiết kiệm thời gian, dữ liệu và tài nguyên nhờ kế thừa mô hình cũ. |

| Hiệu suất khi dữ liệu ít | Hiệu quả kém khi dữ liệu huấn luyện hạn chế. | Hiệu quả cao hơn nhờ kế thừa trọng số đã học từ dữ liệu lớn trước đó. |

| Tính linh hoạt | Thiếu linh hoạt, mỗi mô hình chỉ tốt cho một tác vụ cụ thể. | Linh hoạt, dễ mở rộng và áp dụng cho nhiều tác vụ tương tự nhau. |

| Ví dụ minh họa | Mô hình phát hiện hình tròn và hình vuông được huấn luyện riêng biệt. | Mô hình học phát hiện hình tròn được tận dụng để học phát hiện hình vuông nhanh hơn. |

Tóm lại, Machine Learning huấn luyện mô hình từ đầu cho từng bài toán, còn Transfer Learning tận dụng kiến thức từ mô hình cũ để giải quyết bài toán mới nhanh hơn, hiệu quả hơn, đặc biệt khi dữ liệu mới còn hạn chế.

Dưới đây là những câu trả lời ngắn gọn cho thắc mắc phổ biến xoay quanh câu hỏi học chuyển giao là gì.

Transfer Learning sử dụng mô hình đã huấn luyện sẵn cho bài toán mới, còn Fine-tuning là bước tinh chỉnh lại mô hình để cải thiện hiệu suất, thường bằng cách huấn luyện thêm với tốc độ học thấp; tuy nhiên nếu không cẩn thận có thể dẫn đến quá khớp (overfitting).

Transfer Learning sẽ không hiệu quả nếu đặc trưng học được từ mô hình gốc không đủ để phân biệt các lớp trong bài toán mới, hoặc khi dữ liệu giữa hai bài toán quá khác nhau. Ngoài ra, xóa bớt các lớp trong mô hình gốc cũng dễ gây quá khớp và giảm hiệu suất mô hình.

Hy vọng rằng những thông tin chia sẻ từ WiOn đã giúp bạn đọc có cái nhìn rõ hơn về Transfer Learning là gì và các xu hướng tiềm năng của công nghệ này. Áp dụng học chuyển giao giúp tiết kiệm tài nguyên huấn luyện và mang đến nhiều cơ hội mới để phát triển các mô hình AI có khả năng học hỏi và thích ứng nhanh chóng.

Thẻ: